บทนำ

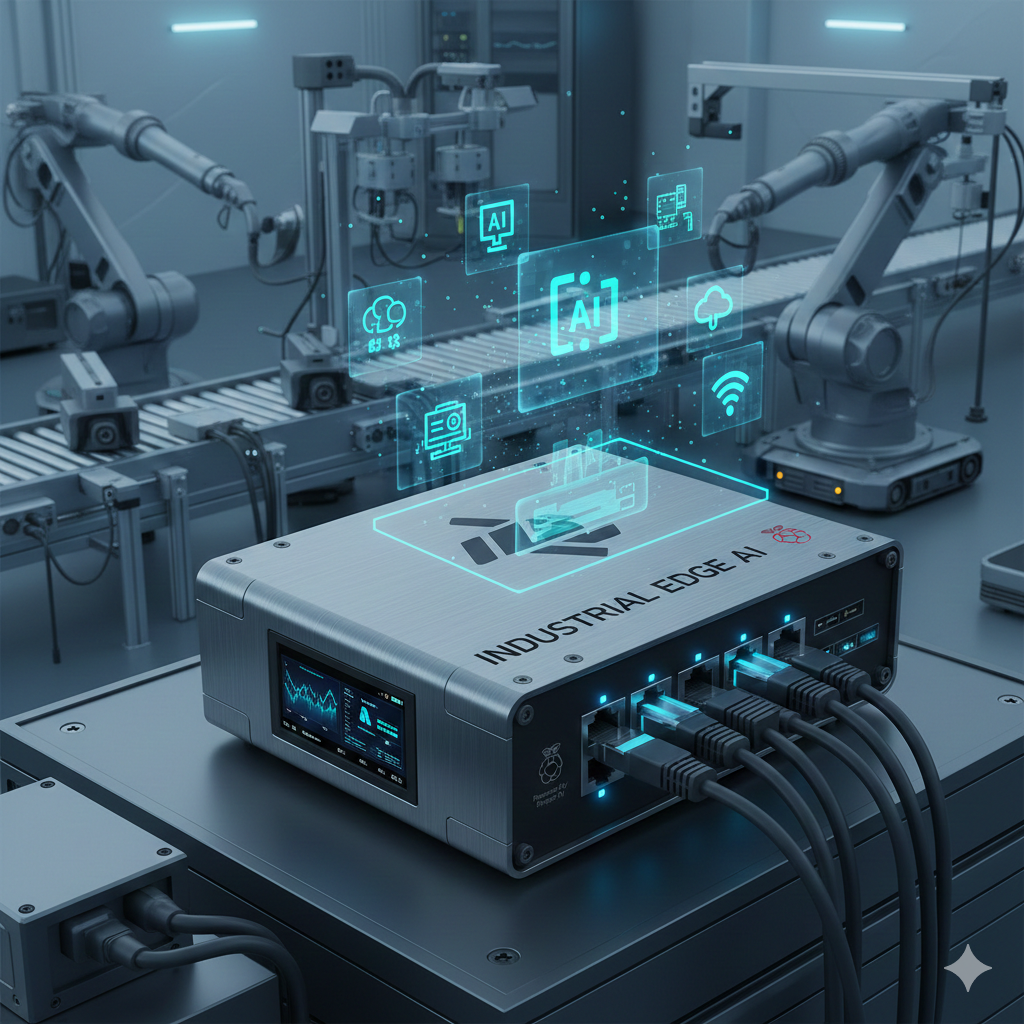

การเติบโตของปัญญาประดิษฐ์ (AI) โดยเฉพาะภายในหมวดของโมเดลภาษาธรรมชาติ ได้พัฒนาอย่างรวดเร็วในช่วงไม่กี่ปีที่ผ่านมา Large Language Models (LLMs) เช่น GPT-4 หรือ LLaMA ได้แสดงให้เห็นศักยภาพอันกว้างขวางในหลายงานทั้งด้านการประมวลผลภาษาธรรมชาติ (NLP) และลอจิกเชิงความคิด อย่างไรก็ตาม การนำไปใช้จริงในระบบที่ต้องการประสิทธิภาพเช่น Edge Computing — ที่การประมวลผลต้องเกิดบนอุปกรณ์ปลายทางโดยไม่อาศัยคลาวด์ — เผชิญกับข้อจำกัดด้านทรัพยากรอย่างชัดเจน โดยเฉพาะความต้องการสูงด้านหน่วยความจำ การประมวลผล และพลังงานไฟฟ้า จากความท้าทายเหล่านี้จึงเกิดกระแสของ Small Language Models (SLMs) ที่ได้รับการพัฒนาเพื่อรองรับสภาพแวดล้อมที่ทรัพยากรจำกัด พร้อมทั้งขยายศักยภาพให้การใช้งาน AI แบบกระจายไปสู่อุปกรณ์ Edge หลายรูปแบบอย่างเป็นรูปธรรมยิ่งขึ้น ทั้งในระดับอุตสาหกรรมและการใช้งานทั่วไป (TechTarget)

1. นิยามและข้อจำกัดของ LLMs ในบริบท Edge Computing

Large Language Models (LLMs) หมายถึงโมเดลภาษาที่มีพารามิเตอร์จำนวนมาก ตั้งแต่หลายสิบพันล้านจนถึงหลายแสนล้านพารามิเตอร์ ซึ่งได้รับการฝึกด้วยชุดข้อมูลขนาดใหญ่เพื่อทำงานหลากหลายรูปแบบ เช่น การสร้างข้อความ การแปลภาษา หรือการตอบคำถามทั่วไป แม้ LLMs จะทรงพลัง แต่ ข้อจำกัดในบริบท Edge นั้นชัดเจน:

ความต้องการด้านทรัพยากรสูง: การรันโมเดลขนาดใหญ่บนอุปกรณ์ปลายทาง เช่น โทรศัพท์มือถือ หรือระบบ IoT จะต้องการหน่วยความจำและการคำนวณที่เกินกว่าความสามารถของฮาร์ดแวร์ทั่วไป ซึ่งทำให้ต้องพึ่งพาเซิร์ฟเวอร์คลาวด์เป็นหลัก (ScienceDirect)

พลังงานและพลังประมวลผล: อุปกรณ์ Edge โดยทั่วไปมีข้อจำกัดด้านพลังงาน จึงไม่เหมาะสมกับการประมวลผลโมเดลขนาดใหญ่ที่ต้องใช้พลังงานมากและเวลาตอบสนองสูง (TechTarget)

ความเป็นส่วนตัวของข้อมูล: การส่งข้อมูลไปยังคลาวด์เพื่อให้ LLM ประมวลผล อาจสร้างความกังวลด้านความปลอดภัย และข้อบังคับด้านข้อมูลส่วนบุคคลอย่าง GDPR เป็นต้น

ด้วยเหตุนี้ แทนที่จะพยายามนำ LLM ขนาดใหญ่ไปยัง Edge โดยตรง นักวิจัยและผู้ปฏิบัติงานด้าน AI หันมาสำรวจแนวคิดของ Small Language Models (SLMs) เพื่อเอาชนะข้อจำกัดเหล่านี้โดยแท้จริง (TechTarget)

2. การเกิดขึ้นของ SLMs: แนวคิดและปรัชญาการออกแบบ

Small Language Models (SLMs) ถูกนิยามโดยทั่วไปว่าเป็นโมเดลภาษาที่มีพารามิเตอร์น้อยกว่ามาก เมื่อเทียบกับ LLMs—มักอยู่ในช่วงตั้งแต่หลักสิบล้านจนถึงไม่เกินหลักพันล้านพารามิเตอร์ — แต่ยังคงสามารถทำงานในระดับที่ตอบสนองต่อความต้องการเฉพาะภารกิจด้านภาษาหรือข้อมูลที่กำหนดได้ดี (Forbes)

แนวคิดหลักของ SLM มุ่งไปที่:

ประสิทธิภาพเชิงทรัพยากร: ออกแบบให้ใช้พลังงานและความจำต่ำ เหมาะกับอุปกรณ์ที่มีขีดจำกัดด้านฮาร์ดแวร์ เช่น Raspberry Pi, อุปกรณ์ IoT หรืออุปกรณ์สวมใส่ (Prem AI)

ความสามารถในการปรับแต่ง: โดยเฉพาะในระดับองค์กร SLM เป็นเครื่องมือในการสร้างโมเดลที่ตอบโจทย์เฉพาะด้าน (domain-specific) ได้อย่างรวดเร็วและคุ้มค่า (Forbes)

การประมวลผลใกล้แหล่งกำเนิดข้อมูล: เพื่อให้การตอบสนองแบบเรียลไทม์และลดการพึ่งพาเครือข่ายคลาวด์ (Runpod)

ปรัชญาการออกแบบนี้ตรงกับแนวคิด Edge AI ที่ต้องการ “ความฉลาดที่อยู่ใกล้กับจุดปฏิบัติการ” มากกว่าการพึ่งพา AI ที่อยู่ห่างไกลทางคลาวด์ ทำให้ SLMs กลายเป็นฟันเฟืองสำคัญในการผลักดัน Edge AI แท้จริง (TechTarget)

3. เทคนิคหลักที่ทำให้ SLMs ใช้งานบน Edge ได้จริง

เพื่อให้ SLMs ใช้งานได้จริงบนอุปกรณ์ Edge มี เทคนิคด้านโมเดลและระบบ หลักที่ได้รับความสนใจอย่างกว้างขวาง:

การลดขนาดและการบีบอัดโมเดล (Compression & Quantization) – การลดความแม่นยำของตัวเลขและโครงสร้างในโมเดล ทำให้ขนาดเล็กลงและเร็วขึ้น โดยไม่สูญเสียประสิทธิภาพมากนัก (Forbes)

การ Distillation และ Fine-Tuning – ใช้โมเดลใหญ่เป็น “ครู” สอน SLM “นักเรียน” ให้เรียนรู้พฤติกรรมที่เป็นประโยชน์ โดยเรียนรู้จากตัวอย่างเฉพาะงาน ลดภาระการฝึกโมเดลจากศูนย์ (Forbes)

ประสานฮาร์ดแวร์กับซอฟต์แวร์ (Co-Design) – ออกแบบ SLM ให้ทำงานร่วมกับอุปกรณ์เฉพาะทาง เช่น NPUs หรือหน่วยประมวลผลเฉพาะทางของอุปกรณ์ เพื่อเพิ่ม Throughput และลด Latency (ACL Anthology)

สถาปัตยกรรมแบบ Hybrid และ Hierarchical Routing – ผสานใช้งาน SLM หลายระดับ หรือผสานกับระบบคลาวด์เมื่อต้องใช้การประมวลผลระดับสูง เพื่อให้เกิดความเท่า-เทียมระหว่างการตอบสนองแบบ Local และ Global (Runpod)

เทคนิคเหล่านี้เป็นหัวใจสำคัญในการทำให้ SLM ไม่ใช่เป็นเพียงแนวคิดเชิงทฤษฎี แต่สามารถนำไปใช้งานจริงบนอุปกรณ์ Edge ได้อย่างมีประสิทธิภาพและเชิงเศรษฐศาสตร์ (Forbes)

4. SLMs กับการสร้าง Specialist Models ในระดับองค์กร

หนึ่งในแนวโน้มสำคัญคือการเดินหน้าจากโมเดล “ทั่วไป” ไปสู่ โมเดลเฉพาะทาง (Specialist Models) ซึ่ง SLM มีศักยภาพโดดเด่น:

ปรับแต่งเฉพาะแอปพลิเคชัน – องค์กรสามารถสร้างโมเดลที่เน้นงานเฉพาะด้าน เช่น วิเคราะห์เอกสารเฉพาะฐานข้อมูลคนไข้ ระบบสนับสนุนด้านกฎหมาย หรือระบบควบคุมคุณภาพในโรงงาน ทำให้โมเดลมีประสิทธิผลสูงกว่าการใช้ LLM ทั่วไป (Forbes)

การสอนเฉพาะงานและกระบวนการ Fine-Tuning ที่เหมาะสม – SLM ที่ผ่านการฝึกแบบ Parameter-Efficient Fine-Tuning สามารถถูกนำไปใช้งานจริงบนอุปกรณ์ Edge โดยไม่ต้องอาศัยศูนย์ข้อมูลขนาดใหญ่ในการฝึกซ้ำ (Prem AI)

การจัดการแบบ Federated Learning – องค์กรสามารถให้ Edge Node หลายจุดเรียนรู้ในสภาพแวดล้อมเฉพาะของตัวเอง แล้วรวมผลการเรียนรู้เข้าด้วยกันโดยไม่ต้องส่งข้อมูลดิบกลับไปยังศูนย์กลาง ซึ่งช่วยลดความเสี่ยงด้านความเป็นส่วนตัว (Runpod)

ทั้งนี้ การประยุกต์ใช้ SLM เพื่อสร้าง Specialist Models ยังช่วยให้ระบบมีความมั่นคงและเป็นไปตามมาตรฐานด้านกฎหมายและข้อบังคับในบางอุตสาหกรรมที่เข้มงวดด้านข้อมูลส่วนบุคคล (Forbes)

5. ภาพรวมจากงานสำรวจล่าสุด: Edge LLM Deployment

จากการศึกษาวิจัยและบทความเชิงวิชาการล่าสุด SLMs กำลังได้รับการประเมินอย่างรอบด้าน:

งานวิจัยในวงการวิชาการชี้ให้เห็นว่า SLMs บางรุ่นสามารถทำงานได้เทียบเท่ากับโมเดลขนาดใหญ่ระดับ 7B ในงานเฉพาะบางประเภท แม้ว่าการเรียนรู้แบบ “in-context” จะยังจำกัดอยู่ก็ตาม (ACL Anthology)

การสำรวจเทคโนโลยีและโมเดลแสดงให้เห็นว่าโมเดล SLM ที่มีพารามิเตอร์ในช่วงไม่ถึงพันล้านนั้นถูกนำมาใช้จริงในหลายระบบ ตั้งแต่ระบบสนับสนุนลูกค้าไปจนถึงการวิเคราะห์ข้อมูลภาคสนาม (Runpod)

แนวโน้มของ Edge AI ยังทำให้เห็นว่าการรวมกันของ SLM และระบบโครงสร้างพื้นฐาน Edge-Cloud แบบไฮบริด จะเป็นรูปแบบสำคัญในอนาคต เพื่อให้ได้ทั้งการตอบสนองแบบทันทีและข้อได้เปรียบจากโมเดลศูนย์กลาง (Dell)

โดยภาพรวม แนวโน้มในปี 2025–2026 ชี้ให้เห็นว่า SLM จะยังคงเติบโตและน่าจะกลายเป็นแพลตฟอร์มหลักสำหรับงาน Edge AI ที่ต้องการทั้งความเร็ว ความปลอดภัย และความประหยัดด้านทรัพยากร (Forbes) Small Language Models (SLMs) กำลังเปลี่ยนแปลงบทบาทของ AI ในบริบท Edge โดยตอบโจทย์ข้อจำกัดของ LLMs ในแง่ของทรัพยากร การประมวลผล และความเป็นส่วนตัว ด้วยแนวคิดที่เน้นประสิทธิภาพและปรับแต่งเฉพาะกิจ SLMs ไม่เพียงแต่ลดข้อจำกัดด้านฮาร์ดแวร์ แต่ยังเปิดโอกาสใหม่สำหรับระบบ AI ที่กระจายตัวไปยังจุดปฏิบัติการจริง นับจากนี้ SLMs จะกลายเป็นองค์ประกอบสำคัญในสถาปัตยกรรม Edge AI ระดับองค์กร ซึ่งต้องผสานเทคนิคด้านโมเดลเฉพาะทาง ระบบฮาร์ดแวร์ที่สอดคล้อง และแนวทางการจัดการข้อมูลเพื่อให้เกิดประโยชน์สูงสุดในการใช้งานจริง

6. ข้อเสนอแนะในการเลือก Small Language Models สำหรับใช้งานบน Raspberry Pi 5 และ Radxa 5 Series

การเลือก SLM ให้เหมาะสมกับ Single Board Computer (SBC) อย่าง Raspberry Pi 5 หรือ Radxa 5 จำเป็นต้องพิจารณาร่วมกันทั้งด้าน สถาปัตยกรรมฮาร์ดแวร์ และ ลักษณะงาน (workload) ไม่ใช่เพียงจำนวนพารามิเตอร์ของโมเดลเพียงอย่างเดียว

6.1 ข้อจำกัดเชิงฮาร์ดแวร์ของ SBC ระดับ Edge

แม้ Raspberry Pi 5 และ Radxa 5 จะมีสมรรถนะสูงกว่ารุ่นก่อนหน้าอย่างชัดเจน แต่ยังมีข้อจำกัดสำคัญ ได้แก่

หน่วยความจำ (RAM)

Raspberry Pi 5: 4–8 GB

Radxa 5: สูงสุด 16 GB (ขึ้นกับรุ่น)

ไม่มี GPU สำหรับงาน AI ขนาดใหญ่

การเร่งความเร็วต้องพึ่ง CPU, NPU ภายนอก หรือ Accelerator เฉพาะทาง

พลังงานและการจัดการความร้อน

การรันโมเดลต่อเนื่องต้องคำนึงถึง Thermal Throttling

ข้อจำกัดเหล่านี้ทำให้ SLMs ที่เหมาะสมควรอยู่ในช่วงไม่เกิน ~0.5–2B parameters และต้องรองรับการ quantization อย่างมีประสิทธิภาพ

6.2 กลุ่มโมเดลที่เหมาะสมสำหรับ Raspberry Pi 5 / Radxa 5

ในเชิงแนวคิด โมเดลที่เหมาะสมสามารถแบ่งออกเป็น 3 กลุ่มหลักตามลักษณะการใช้งาน

1) Ultra-Light SLMs (≤ 500M parameters)

เหมาะสำหรับงานที่ต้องการ latency ต่ำ และรันบน CPU เป็นหลัก

ลักษณะเด่น:

รันได้ด้วย INT8 / INT4 quantization

ใช้ RAM ต่ำ (<2–3 GB)

เหมาะกับ keyword extraction, command understanding, document classification

ตัวอย่างแนวคิดโมเดล:

Distilled Transformer Models

Domain-Specific Encoder-Decoder Models

Instruction-tuned compact models

เหมาะกับ: Raspberry Pi 5 (4GB), งาน IoT, ระบบควบคุมอุปกรณ์, HMI

2) Mid-Size SLMs (0.7–1.5B parameters)

เป็นจุดสมดุลระหว่างความสามารถด้านภาษาและข้อจำกัดของ SBC

ลักษณะเด่น:

รองรับงาน reasoning ระดับพื้นฐาน

ใช้ RAM 4–8 GB (เมื่อ quantized)

รองรับ RAG (Retrieval-Augmented Generation) ขนาดเล็ก

เหมาะกับ:

Raspberry Pi 5 (8GB)

Radxa 5

ระบบผู้ช่วยภายในองค์กร, วิเคราะห์เอกสารเฉพาะทาง

3) Hybrid Edge Models (SLM + Cloud Fallback)

ไม่จำเป็นต้องให้ SLM ทำทุกอย่าง

แนวคิด:

SLM บน Edge ทำงานหลัก 70–80%

ส่งเฉพาะกรณีซับซ้อนขึ้นไปยัง LLM บนคลาวด์

ลดต้นทุนและ Latency โดยรวม

เหมาะกับ:

งานที่ต้องการความแม่นยำสูงบางช่วง

SME ที่ยังไม่พร้อมลงทุนโครงสร้าง AI เต็มรูปแบบ

6.3 แนวทางเทคนิคในการปรับใช้ SLMs บน SBC

การเลือกโมเดลเพียงอย่างเดียวไม่เพียงพอ ต้องออกแบบ ระบบ ควบคู่กัน

แนวทางที่แนะนำ:

Quantization-First Deployment

ออกแบบ pipeline ให้รองรับ INT8/INT4 ตั้งแต่ต้น

Use Case-Driven Fine-Tuning

ฝึกเฉพาะข้อมูลจริงขององค์กร แทนการใช้โมเดลทั่วไป

Context Limitation Strategy

จำกัด context window ให้เหมาะกับงานจริง เพื่อลด memory footprint

Pair with Vector Search

ใช้ SLM ร่วมกับ vector database ขนาดเล็ก เพื่อเพิ่มความรู้โดยไม่เพิ่มขนาดโมเดล

7. แนวคิดการปรับใช้ SLMs ในบริบท SME ของไทย

สำหรับ SME ไทย การนำ SLMs ไปใช้ควรถูกมองเป็น เครื่องมือเพิ่มประสิทธิภาพ มากกว่าการแข่งขันด้านเทคโนโลยีกับองค์กรขนาดใหญ่

7.1 หลักคิดสำคัญ: “เล็ก แต่เฉพาะทาง”

SME มักมีลักษณะ:

ข้อมูลไม่ใหญ่มาก

กระบวนการทำงานซ้ำ ๆ

ความรู้เฉพาะทางสูง (tacit knowledge)

SLMs เหมาะอย่างยิ่งกับบริบทนี้ เพราะสามารถ:

เรียนรู้จากเอกสารภายใน

ฝังความรู้ของผู้เชี่ยวชาญ

ทำงานแบบ offline ได้

7.2 ตัวอย่าง Use Case ที่เหมาะกับ SME ไทย

ผู้ช่วยเอกสารบัญชีและภาษี

วิเคราะห์เอกสาร, ตรวจความสอดคล้อง, สรุปรายการ

ระบบผู้ช่วยภายในโรงงานหรือคลังสินค้า

ตอบคำถามจากคู่มือ, SOP, หรือ Log การทำงาน

Customer Support แบบ Local AI

ทำงานบน Edge ลดต้นทุน Call Center

Edge AI สำหรับภาคการเกษตรหรือพลังงาน

วิเคราะห์ข้อมูลภาคสนามโดยไม่ต้องพึ่งอินเทอร์เน็ตตลอดเวลา

7.3 Roadmap การเริ่มต้นที่เหมาะสมสำหรับ SME

เริ่มจาก SLM เดียว + Use Case เดียว

ไม่จำเป็นต้อง “AI ทั้งองค์กร” ตั้งแต่แรก

Deploy บน SBC ต้นทุนต่ำ

เช่น Raspberry Pi 5 หรือ Radxa 5

Fine-Tune จากข้อมูลจริง

ไม่เน้น Big Data แต่เน้น Relevant Data

ขยายเป็น Hybrid Edge-Cloud เมื่อจำเป็น

ค่อยพัฒนาเป็น Specialist Models หลายตัว

แนวทางนี้ช่วยลดความเสี่ยง และทำให้ SME สามารถควบคุมต้นทุนด้าน AI ได้อย่างยั่งยืน

บทส่งท้ายเพิ่มเติม

ในบริบทของ Edge AI และเศรษฐกิจดิจิทัลของไทย Small Language Models ไม่ใช่เพียงทางเลือกสำรองของ LLMs แต่เป็นแนวทางหลัก สำหรับองค์กรที่ต้องการความคล่องตัว ความเป็นส่วนตัวของข้อมูล และการใช้งานจริงบนฮาร์ดแวร์ที่จับต้องได้ การผสาน SLMs เข้ากับ SBC อย่าง Raspberry Pi 5 หรือ Radxa 5 จึงไม่ใช่เรื่องเชิงทดลองอีกต่อไป แต่กำลังกลายเป็นสถาปัตยกรรม AI ที่เหมาะสมกับ SME ไทยในระยะกลางถึงระยะยาว